Подземные убежища на Гавайях, «апокалиптическая страховка» и страх перед ИИ. Чего опасаются техномиллиардеры, о чем мы не знаем?

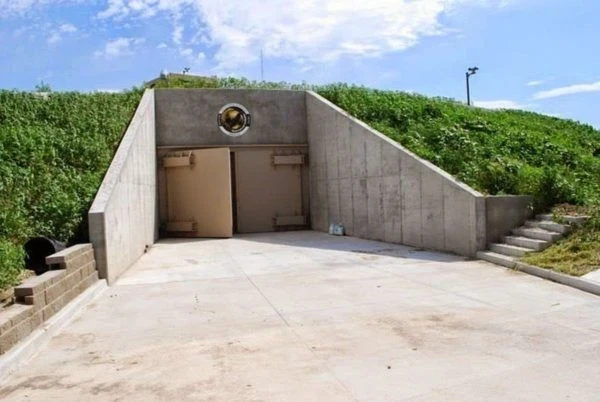

Среди технологических миллиардов наблюдается рост интереса к созданию безопасных домов и бункеров. Наиболее заметные фигуры, такие как Марк Цукерберг, строят обширные комплексы на Гавайях, в то время как Рид Хоффман открыто рассказывает о своей «апокалиптической страховке» в виде недвижимости, в том числе в Новой Зеландии. Это создает впечатление, что богатые готовятся к возможному социальному коллапсу или климатическим катастрофам.

Защита — это не опция. Это необходимость.

Подпишись на нас

Причины такого поведения усиливаются заявлениями представителей индустрии искусственного интеллекта. Сооснователь OpenAI Илья Суцкевер, по сообщениям, заявил, что «мы обязательно создадим бункер перед тем, как выпустить AGI». Некоторые лидеры отрасли, включая Сэма Альтмана и Демиса Хассабиса, предсказывают, что AGI появится в ближайшие десять лет. Однако скептики утверждают, что такой оптимизм преждевременен и отвлекает внимание от более насущных проблем.

Многие ученые считают обсуждение «суперинтеллекта» отвлекающим маневром. Гораздо более актуальны риски, связанные с существующими технологиями, такие как предвзятость, распространение дезинформации и угроза для рабочих мест. Профессор Нил Лоуренс подчеркивает, что сам термин AGI не совсем корректен, указывая на то, что интеллект всегда зависит от контекста. Он предлагает рассмотреть концепцию универсального «искусственного транспортного средства», что, по его мнению, является нереалистичной идеей. Вместо этого он считает, что важнее разобраться в том, как текущие технологии влияют на общество и экономику.

Различные государства также по-разному подходят к регулированию ИИ. В США администрация Джо Байдена пыталась ввести обязательные меры по тестированию безопасности ИИ, но вскоре изменила курс, посчитав некоторые из этих требований препятствием для инноваций. В Великобритании создан AI Safety Institute, который исследует риски и публикует оценки. Политические дебаты продолжаются, но научное сообщество придерживается более скромных взглядов, чем громкие заявления из индустрии.

BBC отмечает, что «апокалиптическая подготовка» среди богатых людей может отражать как реальный страх перед новыми технологиями, так и стремление продемонстрировать статус. В то время как эти проекты могут выглядеть внушительно, научное сообщество не ожидает скорого появления AGI и «суперинтеллекта». Гораздо более разумно сосредоточиться на том, как уже существующие алгоритмы меняют общество и кому они приносят выгоды или риски, чем готовить чемоданы для бункера.

Читайте также: